Chiar și în timp ce furnizorii de procesoare lucrează la integrarea AI accelerată pentru PC-urile client, iar Microsoft stabilește ritmul pentru mai multă AI în aplicațiile de zi cu zi cu Windows 11 23H2 Update; NVIDIA vă reamintește că fiecare GPU GeForce RTX este un accelerator AI. Acest lucru se datorează nucleelor sale Tensor și mușchiului SIMD al omniprezentelor nuclee CUDA. NVIDIA le produce de peste 5 ani și are o bază de instalare de peste 100 de milioane de unități. Prin urmare, compania se concentrează să aducă accelerarea AI generativă la cazuri de utilizare mai relevante pentru clienți și pasionați, cum ar fi modelele lingvistice de mari dimensiuni.

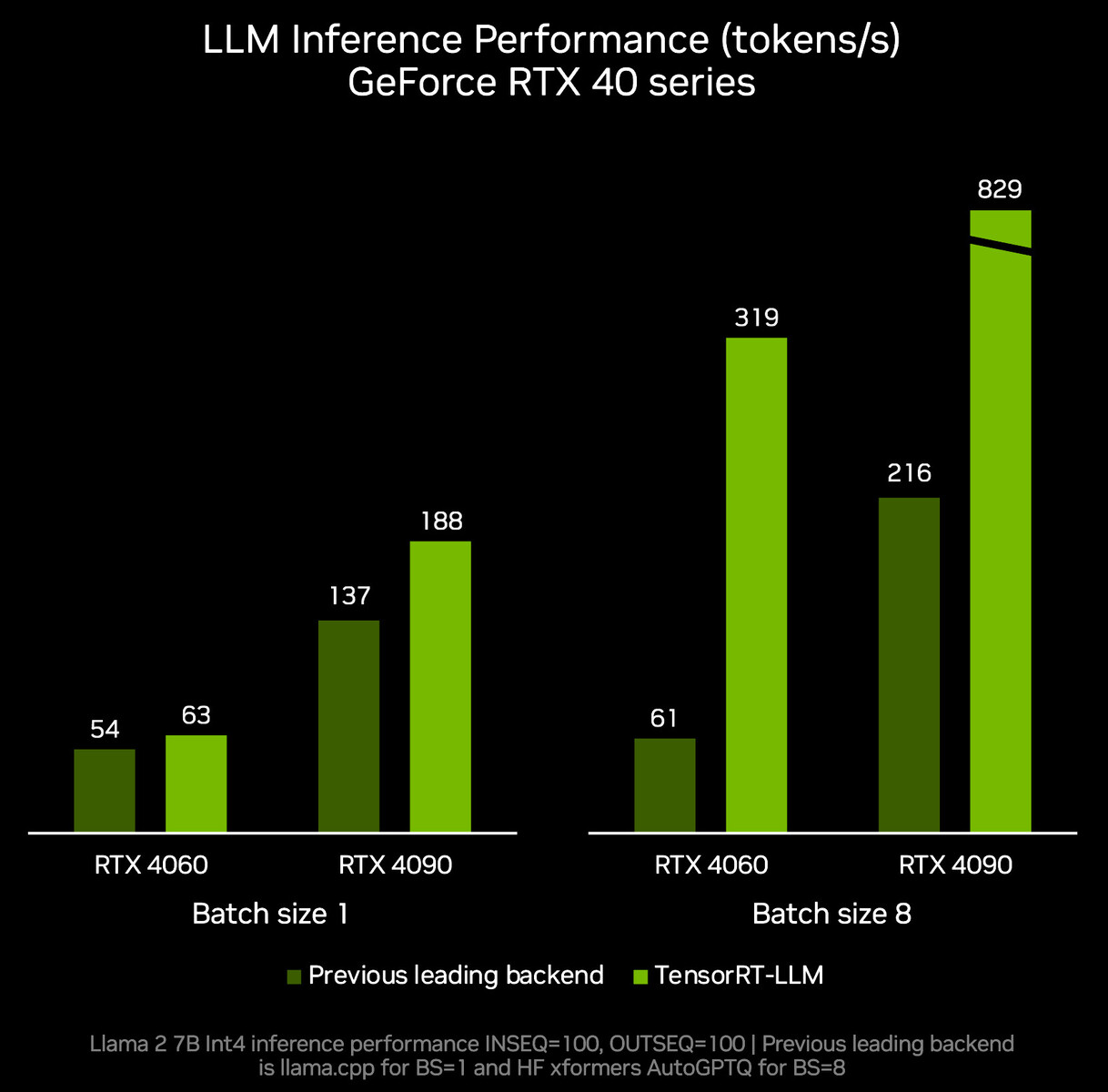

În cadrul evenimentului Microsoft Ignite, NVIDIA a anunțat noi optimizări, modele și resurse pentru a oferi AI accelerată tuturor celor care dispun de un GPU NVIDIA care îndeplinește cerințele hardware. Pentru început, compania a prezentat o actualizare a TensorRT-LLM pentru Windows, o bibliotecă care valorifică arhitectura NVIDIA RTX pentru accelerarea modelelor de limbaj de mari dimensiuni (LLM). Noua versiune 0.6.0 a TensorRT-LLM va fi lansată la sfârșitul acestei luni și va îmbunătăți performanța inferenței LLM de până la 5 ori în ceea ce privește token-urile pe secundă, în comparație cu versiunea inițială a TensorRT-LLM din octombrie 2023. În plus, TensorRT-LLM 0.6.0 va introduce suport pentru LLM-urile populare, inclusiv Mistral 7B și Nemtron-3 8B. Accelerarea acestora două va necesita un GPU GeForce RTX seria 30 „Ampere” sau seria 40 „Ada” cu cel puțin 8 GB de memorie principală.

ChatGPT de la OpenAI este cea mai populară aplicație pentru consumatori de la Google încoace, dar este un serviciu bazat pe cloud, care presupune transmiterea de informații prin internet și este limitat în ceea ce privește dimensiunea seturilor de date, ceea ce îl face nepractic pentru întreprinderile sau organizațiile care au nevoie de o confidențialitate infailibilă a datelor și de o scalare nelimitată a seturilor de date, ceea ce numai o inteligență artificială localizată poate oferi. NVIDIA va permite în curând ca TensorRT-LLM pentru Windows să suporte o interfață similară cu ChatAPI prin intermediul unui nou wrapper. NVIDIA spune că, pentru cei care dezvoltă aplicații în jurul ChatAPI, este nevoie de modificarea a doar 2 linii de cod pentru a beneficia de AI locală. Noul wrapper va funcționa cu orice LLM care este optimizat pentru TensorRT-LLM, cum ar fi Llama 2, Mistral și NV LLM. Compania plănuiește să lanseze acest lucru ca proiect de referință pe GitHub.

NVIDIA colaborează cu Microsoft pentru a accelera Llama 2 și Stable Diffusion pe RTX prin intermediul unor noi optimizări API-ul DirectML. Dezvoltatorii le pot experimenta descărcând cel mai recent runtime ONNX împreună cu o nouă versiune viitoare a driverelor NVIDIA GeForce pe care compania o va lansa pe 21 noiembrie 2023.

Leave a Review